🌐 Bentornato/a su AI News 24, la tua newsletter quotidiana realizzata da Marketing Hackers. Oggi abbiamo un menu particolarmente ricco per te, che porterà la tua conoscenza dell’intelligenza artificiale a nuovi livelli.

🔍 Oggi, esaminiamo i cambiamenti recenti che stanno attirando l’attenzione: da Meta che combatte a modo suo le immagini create da AI, a DeepMind che dà espressioni ai robot, fino a Mastercard che si appoggia all’AI per la sicurezza bancaria. Inoltre, abbiamo gli ultimi aggiornamenti sulle innovazioni di Apple nell’editing di immagini e nei linguaggi AI, e un’occhiata a come Stability AI impiega l’IA per creare video più realistici.

Meta Lancia una Nuova Strategia Contro le Immagini generate con l’AI

*Meta ha rivelato un piano per marcare le immagini create da intelligenza artificiale (AI) su Facebook, Instagram e Threads con avvisi sulla loro natura artificiale. L’obiettivo è combattere la disinformazione. Meta tende sempre ad una politica censoria a discapito degli utenti e sempre poco efficace data la mancanza di uno standard condiviso, la semplicità nel superare le tecnologie dei watermark e gli errori ricorrenti di cui ogni giorno siamo testimoni. La Coalition for Content Provenance and Authenticity (C2PA) sta cercando di uniformare gli standard di watermark, ma ci sono ostacoli, inclusa l’identificazione dei contenuti AI non marcati e l’etichettatura di contenuti audio e video AI.

🔗 Fonte: Meta Will Crack Down on AI-Generated Fakes—But Leave Plenty Undetected

DeepMind’s GenEM: Robot Espressivi e sempre più umanoidi.

GenEM di DeepMind, acronimo di Generative Expressive Motion, sfrutta i Large Language Models (LLM) per dare ai robot comportamenti espressivi, permettendogli di comunicare come gli umani con gesti e risposte. Sviluppata da ricercatori dell’Università di Toronto, Google DeepMind e Hoku Labs, GenEM brilla per la sua flessibilità e la sua capacità di adattarsi sia al feedback umano che a diversi tipi di robot. A differenza dei sistemi tradizionali, che sono inflessibili e complessi, GenEM usa metodi innovativi per capire gli ambienti e creare comportamenti usando le capacità del robot. Questo approccio permette espressioni che includono parole e movimenti, e migliora con il feedback umano in tempo reale. GenEM lavora con istruzioni semplici, pensiero logico e ingegneria delle sollecitazioni, evitando la necessità di un lungo addestramento o di stabilire regole. Grazie a GPT-4 di OpenAI, questa tecnica ha mostrato un grande potenziale in test iniziali per sviluppare comportamenti espressivi avanzati senza bisogno di dati specializzati. Ancora, si richiede più ricerca, specialmente per robot con maggiori capacità d’azione.

Fatti un giro nel futuro https://generative-expressive-motion.github.io/

Mastercard Utilizza AI Generativa per la Sicurezza Bancaria

Mastercard ha introdotto uno strumento di AI generativa, Decision Intelligence Pro, per migliorare la protezione contro le frodi per banche e consumatori. Questo strumento di AI analizza un trilione di data point per esaminare le transazioni in tempo reale, aumentando la capacità di individuare frodi del 20% in media e fino al 300% in alcuni casi. Decision Intelligence Pro esamina le connessioni tra conti, dettagli degli acquisti, commercianti e dispositivi, diminuendo i falsi allarmi di oltre l’85%. L’iniziativa, che mira a fronteggiare l’incremento delle frodi sfruttate da AI, è volta a intensificare la sicurezza informatica e la fiducia nelle transazioni digitali. Il suo lancio è previsto entro la fine dell’anno.

Ajay Bhalla, presidente di cyber e intelligence di Mastercard, ha evidenziato come questa tecnologia possa migliorare gli sforzi antifrode grazie all’accresciuta velocità, accuratezza e affidabilità. In aggiunta, Dynamic Yield, una filiale di Mastercard, ha presentato Shopping Muse, uno strumento di vendita al dettaglio basato su AI generativa che ottimizza lo shopping online. Capisce il linguaggio quotidiano dei consumatori per proporre raccomandazioni personalizzate. 🛍️

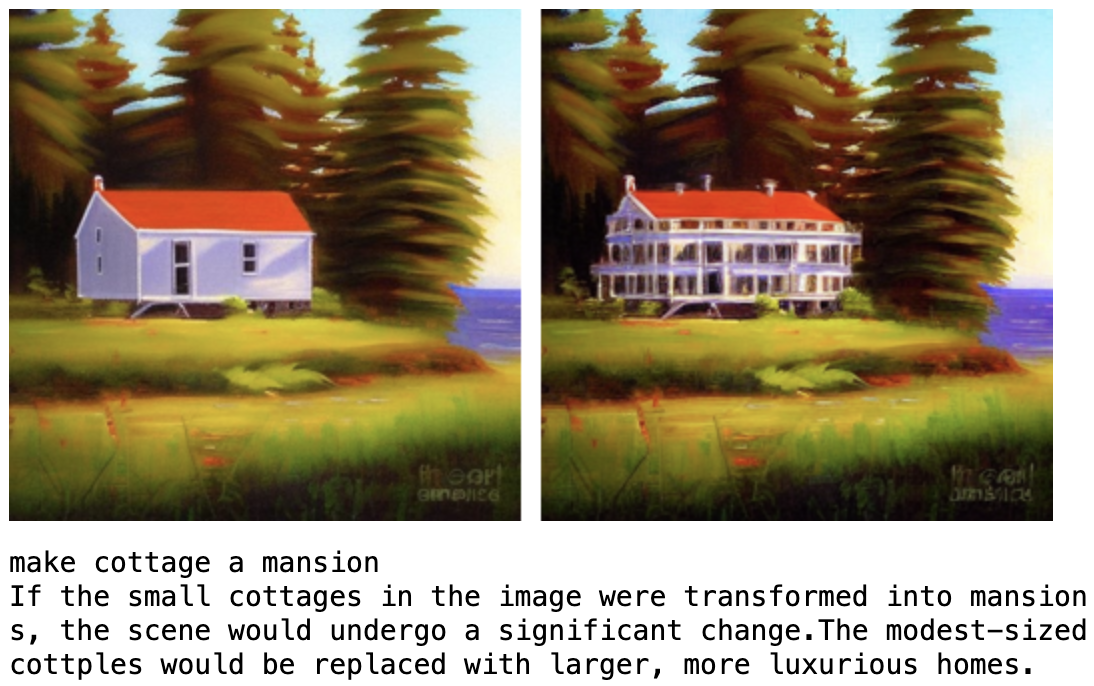

Apple Presenta ‘MGIE’, un Modello AI Open-Source per l’Editing di Immagini con Istruzioni Naturali

Apple ha introdotto ‘MGIE’ (MLLM-Guided Image Editing), un innovativo modello di intelligenza artificiale open-source. Questo strumento, pensato per modificare le immagini tramite istruzioni in linguaggio naturale, sfrutta i modelli di linguaggio multimodali di grandi dimensioni (MLLM) per decifrare i comandi degli utenti e apportare modifiche precise a livello di pixel. Realizzato in partnership con l’Università della California, Santa Barbara, MGIE ha fatto il suo debutto alla conferenza ICLR 2024, dimostrando di potenziare sia le metriche automatiche che la valutazione umana, senza rinunciare all’efficienza dell’inferenza. Grazie agli MLLM, il modello è capace di interpretare istruzioni dettagliate dagli input degli utenti, come “modifica la saturazione del cielo”, creando una ‘immaginazione visiva’ che orienta l’editing. MGIE supporta diversi contesti di editing, è disponibile per demo su GitHub e Hugging Face Spaces e punta a promuovere interazioni cross-modali e la creatività supportata dall’intelligenza artificiale in svariate situazioni di utilizzo.

Scopri di più su MGIE

Provalo su Hugging face

Google Gemini Ultra: bye bye Bard? Non ci mancherai.

Google sembra pronta a sostituire il brand Bard con il suo modello di intelligenza artificiale Gemini, introducendo Gemini Ultra. Questa novità potrebbe superare il modello GPT-4 di OpenAI. Gemini, presentato a dicembre, include versioni come Nano e Gemini Pro. Questo cambiamento di nome potrebbe portare a identificare tutti gli strumenti AI di Google come ‘Google Gemini’. Un changelog trapelato rivela il lancio di Gemini Ultra e un chatbot aggiornato e più facile da usare. Gemini Advanced, una versione premium del chatbot, offre funzionalità avanzate di codifica, ragionamento logico e collaborazione creativa. Verrà lanciato inizialmente negli Stati Uniti, con piani di espansione mondiale esclusi Regno Unito, Svizzera e Area Economica Europea (che la VPN ci aiuti) a causa delle normative sulla privacy. Il servizio potrebbe offrire un periodo di prova gratuito, a differenza dei suoi concorrenti.

Fonte: Google may be rolling out Gemini Ultra this week and renaming Bard at the same time

Stability AI Presenta SVD 1.1 per Video Più Realistici

Stability AI ha lanciato SVD 1.1, un’evoluzione del suo modello per creare video AI brevi con maggiore coerenza e fluidità nel movimento. Questa versione, disponibile su Hugging Face, supera le limitazioni delle precedenti SVD 1.0 e SVD-XT, consentendo di generare video di quattro secondi a 1024x576 di risoluzione con 25 frame. SVD 1.1 garantisce un realismo e una fluidità migliorati, operando a 6FPS e con l’identificativo del bucket di movimento 127. Il modello è accessibile ai ricercatori e tramite vari piani di abbonamento di Stability. Inoltre, Stability AI offre un’API per la per gli sviluppatori, che supporta diverse risoluzioni e il controllo dell’intensità del movimento. Pur affrontando la concorrenza di Runway e Pika, Stability AI conferma la sua leadership grazie a rilasci frequenti di nuovi modelli e un consistente finanziamento.

Se questo aggiornamento ti è stato d’aiuto, potrebbe esserlo anche per il tuo network. Condividi i nostri contenuti per aiutarci a crescere e non dimenticare di iscriverti e attivare le notifiche per non perdere nessuna delle nostre future puntate dedicate all’intelligenza artificiale.